Etika umělé inteligence: kde jsme a proč nevíme, kam dál

David Černý, Jiří Wiedermann

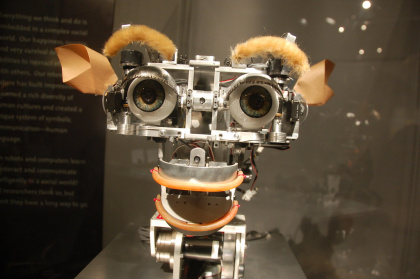

Umělá inteligence (UI) se ve všech svých rozličných podobách a ztělesnění stala za poměrně krátkou dobu všudypřítomnou součástí naší společnosti. Komunikuje s námi v chytrých telefonech, počítačích a tabletech, dohlíží na finanční transakce platebními kartami, dokáže nás porazit v oblastech, v nichž jsme si dlouho mysleli, že nás ohrozit nemůže, jako jsou šachy či populární televizní soutěž Jeopardy! Umělá inteligence poskytuje rady lékařům při řešení obtížných etických dilemat, diagnostikuje některé choroby a je v tom stále lepší a lepší, řídí společenské či záchranářské roboty a v horizontu několika let (možná desetiletí) převezme naše místo řidičů a stane se součástí plně autonomního provozu.

UI může být prospěšná, pokud ji budeme užívat dobře a pro správné účely, může se ale také stát nástrojem rostoucího dohledu státní moci, který nás bude sledovat na každém kroku a dohlížet na to, abychom se chovali přesně tak, jak si stát přeje. Může posílit mechanismy demokratické správy naší společnosti, stejně tak se ale může stát nástrojem jejich potlačování. Může být vynikajícím sluhou, ale velmi špatným pánem. Aby se tak nestalo, je nezbytné najít řešení problému, jak by se UI měla chovat, aby se chovala správně, jakými pravidly by se měla řídit, aby její rozhodování a jednání bylo eticky správné a neubližovalo nám.

Hodnotová dimenze (co je dobré a správné) by měla vstupovat do všech fází vývoje, návrhu designu, testování, implementace a využívání systémů UI. Již samotná existence AI a její účel může mít výrazný etický náboj, jako tomu je například v případě robotických žokejů, kteří se na hřbetech závodních velbloudů prohánějí po závodních drahách Kataru. Kratochvíle bohatých šejků, kteří donedávna v podstatě zotročovali malé chlapce z chudých rodin a nedávali jim dostatečně najíst, aby si udrželi nízkou váhu a výhodu nad jinými žokeji. Jejich robotičtí náhradníci svou existencí umožňují pokračování těchto závodů a třebaže sami nedisponují jednáním, jež by mělo být podřízeno nějakým etickým normám, učinili Katar lepším a eticky korektnějším místem.

Sofistikovanější systémy UI však takto eticky impaktní (jak tyto stroje nazývá známý etik UI z Dartmouth College v USA James H. Moor) nejsou, v jejich případě lze hovořit o funkční morálce, tedy určité „citlivosti“ vůči hodnotám a nějaké míře autonomie. Například medicínský expertní systém MedEthEx, navržený počítačovým vědcem Michaelem Andersonem a jeho ženou, filosofkou Susan Andersonovou, v podstatě žádnou autonomii nemá, je však schopný provádět základní etickou rozvahu a poskytovat lékařům rady při řešení eticky svízelných otázek lékařské praxe. Autopiloti řídící letadla zase mají poměrně vysokou autonomii, jejich „rozvaha“ však není přímo založená na hodnotách, ale spíše na parametrech letu, komfortu a bezpečí pasažérů. Od autonomních vozidel očekáváme, že budou jednoho dne v nedaleké budoucnosti plně autonomní (odvezou nás z bodu A do bodu B po všech běžných typech vozovky) a současně budou disponovat sofistikovaným rozhodovacím mechanismem distribuce újmy v případě kolize. Hudbou budoucnosti potom jsou plnohodnotní morální aktéři – jak jim říkají průkopníci na poli etiky UI Wendell Wallach a Collin Allen –, kteří dokáží nejen formulovat etické soudy a aplikovat je na své vlastní jednání, zvládnou také tyto soudy nějakým způsobem ospravedlnit.

Asimovovy zákony robotiky aneb když roboti blázní

Jak by měla v praxi vypadat pravidla, jimiž by se systémy UI mohly řídit? A jakým způsobem bychom jim tato pravidla měli vštípit? Jednou velmi populární a široce diskutovanou možností je tzv. přístup „shora“: zvolíme si nějaká obecná pravidla jednání, která zabudujeme do příslušného software a prostřednictvím formálního aparátu deontické logiky je obohatíme odvozovacími pravidly.

Myslíme si, že drtivá většina z nás zná amerického vědce a neuvěřitelně plodného spisovatele sci-fi Isaaca Asimova, který společně s Johnem W. Cambellem v roce 1940 formuloval tzv. tři zákony robotiky, jež mu svou obecností a nesnadnou aplikovatelností v praxi – jak Asimov sám přiznává – umožnily stvořit celou řadu nezapomenutelných příběhů. Tyto tři zákony robotiky se poprvé objevily v roce 1942 v povídce Runaround (v češtině Rychlík) a mají následující podobu:

- První zákon: Robot nesmí ublížit člověku, nebo svou nečinností dopustit, aby člověku bylo ublíženo.

- Druhý zákon: Robot musí uposlechnout příkazů člověka, kromě případů, kdy tyto příkazy jsou v rozporu s prvním zákonem.

- Třetí zákon: Robot musí chránit sám sebe před zničením, kromě případů, kdy je tato ochrana v rozporu s prvním nebo druhým zákonem robotiky.

Dohromady tyto zákony představují principy, jež by v praxi měly zajišťovat eticky korektní jednání UI (v Asimovových povídkách a novelách jsou tyto zákony pevnou součástí robotických pozitronických mozků). I dnes má tento přístup některé zastánce (ti však počet těchto zákonů rozšiřují o další, např. o zákon, že robot musí chránit sobě nadřazeného robota, pokud to není v rozporu s jinými zákony, či že musí vykonávat povinnosti, pro něž je určený, opět pokud to neodporuje vyšším zákonům), již Asimov však ve svých povídkách sebraných ve sbírce Já robotukázal, že jeho zákony robotiky mohou UI dostat do svízelných situací. Vezměme si např. první zákon, podle kterého robot nesmí lidem působit újmu nebo dovolit, aby újma nastala. Znamená to, že třeba chirurgický robot by nesměl provést řez do pacientova těla? V první povídce sbírky Já robotvypráví Asimov o Robbiem, který zachránil malou Glorii před řítícím se lokotraktorem a strhnul ji stranou tak silně, že jí vyrazil dech. Bylo jeho jednání porušením 1. zákona, nebo nebylo? Je nepochybné, že Glorii nějakou újmu způsobil, bylo to ale eticky ospravedlněné způsobení újmy? A pokud ano, jakým způsobem se UI má v praxi rozhodovat? Jaká újma je oprávněná a jaká již není? Když robot zabije člověka, aby zachránil sto jiných, je to morálně korektní způsobení újmy?

Obecný problém spojený se všemi přístupy „shora“, nejen tedy s Asimovovými zákony robotiky, spočívá v tom, že jednotlivá pravidla jsou příliš obecná a není zřejmé, jak bychom v nějaké konkrétní situaci měli sestoupit z obecnosti pravidel ke konkrétnosti jedinečného a pro tuto situaci platného morálního soudu. Navíc hrozí, že se jednotlivé zákony dostanou do konfliktu, který ohrozí samotnou možnost UI myslet, přijímat rozhodnutí a jednat. Velmi dobře to ukazuje povídka Rychlík z roku 1942. Dva astronauté pobývající na povrchu Merkuru poslali svého robota Rychlíka k blízkému selénovému jezírku, aby z něj získal selen, nezbytný pro fungování slunečních baterií a samotné přežití obou mužů. Vzhledem k tomu, že selénové jezírko bylo díky jisté anomálii pro robota hrozbou a rozkaz přinést selen nebyl vydaný dostatečně důrazně, došlo ke kolizi druhého a třetího zákona a robot se ocitl ve stavu ekvivalentnímu lidské opilosti; neustále obíhal jezírko po trajektorii odpovídající rovnováze mezi hrozícím nebezpečím a síle druhého zákona. Teprve chladnokrevná úvaha a jednání obou mužů vedly k prosazení prvního zákona v robotově mozku a jeho návratu do normálu. Můžeme si také připomenout povídku Lhář!, v níž robot Herbie náhodou získá schopnost číst myšlenky a řídě se prvním zákonem robotiky, lže lidem kolem sebe, aby jim pravdou neublížil. Výsledkem ale je, že ublížil všem. Všechny tyto problémy ukazují, že vtisknout umělé inteligenci Asimovovy tři zákony robotiky (či nějaké jejich rozšíření) nepředstavuje slibnou metodu vytváření eticky korektní UI.

UI je dobrý počtář… Tak ji nechme počítat

Možná bychom si měli vzít poučení z předchozího nezdaru a namísto několika obecných a v praxi obtížně aplikovatelných pravidel bychom měli zvolit pravidlo jediné, s nímž podobné problémy nebudou. Jak by takové pravidlo mohlo vypadat? Začněme konkrétním příkladem.

Autonomní vozidla (AV) sice sníží počet dopravních nehod (v ideálním případě až o 93 %, protože právě takové množství nehod je způsobeno řidiči), nehodám se však nevyhnou zcela. Jak by se měla v takovém případě rozhodovat? Jednou z možností je, že řídící software AV nejdříve naučíme kategorizovat možnou újmu do tří velkých skupin: majetková, zdravotní a na životech. Posléze vymyslíme nějaký systém kvantifikace těchto forem újmy (můžeme to udělat různými způsoby, které zde ale nemůžeme rozvádět) a do rozhodovacích mechanismu AV vtělíme funkci, která v případě hrozící kolize přiřadí všem možných trajektoriím číslo, udávající celkovou újmu, pokud si AV tuto trajektorii zvolí. A nakonec to nejdůležitější: jediným etickým pravidlem, jimž se AV budou řídit, bude jednoduché pravidlo minimalizace újmy. Řekněme, že se AV musí rozhodnout mezi dvěma trajektoriemi: první povede ke smrti jednoho člověka, druhá ke smrti tří lidí. Protože celková újma je v prvním případě nižší, zvolí si AV tuto variantu, i když svou volbou usmrtí jednoho člověka.

Etika, která požaduje minimalizaci újmy, se nazývá utilitarismus a představuje jeden z nejrozšířenějších etických systémů. Je to celkem pochopitelné, neboť obsahuje pouze jediné pravidlo, které se navíc zřejmě dá velmi dobře aplikovat v praxi. V případě AV jsme viděli její negativní stranu (minimalizaci újmy), má ale také stranu pozitivní (maximalizuj dobro); dobré – eticky správné – jednání je potom prostě takové, jehož důsledky maximalizují dobro (v případě, že má dobré i špatné účinky), nebo které minimalizuje újmu (zaměřujeme-li se pouze na účinky negativní, jako v případě AV).

Je tedy utilitarismus svatým grálem etiky UI? Můžeme s klidným srdcem říci, že všechny systémy UI by se měly řídit touto etikou, a pokud se budou řídit touto etikou, budou jednat správné a pro nás lidi blahodárně? Bohužel, nemůžeme.

Utilitarismus je zvláštní a do značné míry extrémní etika. Říká nám totiž, že máme maximalizovat dobro bez ohledu na to, jak tuto maximalizaci provedeme. V případě AV tak hrozí, že řídící software našeho auta obětuje nás i s rodinou, bude-li to znamenat, že způsobí méně újmy. Kdo z nás by si ale takové auto kupoval? Opravdu bychom našli odvahu sednut si do vozidla, které nemilosrdně prověřuje všechny možné trajektorie jednání a volí způsobem, v němž je jeho posádka pouhým členem morální rovnice rovnocenným se všemi ostatními? A co třeba pečovatelští roboti? Představme si, že si v budoucnosti pořídíme vysoce sofistikovaného robota, který je naprogramovaný pečovat o naše potomky. Přáli bychom si, aby se řídil utilitarismem, i kdyby to znamenalo, že když bude náš potomek v ohrožení života, robot se vydá zachránit jiné dva lidi, kteří se shodou okolností také ocitli v ohrožení života? Tyto problémy ukazují, že třebaže je utilitarismus jednoduchý a v praxi víceméně snadno aplikovatelný, v mnoha případech bychom se jen obtížně smiřovali s tím, kdyby se jím UI řídila.

Dodržuj pravidla a vše bude OK

Problém s utilitarismem, alespoň v té nejznámější podobě, o níž jsme hovořili, spočívá v tom, že neuznává existenci žádných morálních norem, např. normy „nikdy nesmíš zabít nevinného člověka“, „nikdy nesmíš lhát“, „nikdy nesmíš dát přednost ostatním před svým majitelem“ apod. Umělé inteligenci by namísto „nikdy nelži“ uložil, aby spočítala zisky a ztráty a v případě, že jejich poměr nahrává lhaní, klidně by lhala. Viděli jsme však, že této přístup má celou řadu problémů (Směl by např. vojenský robotický systém obětovat několik civilistů, aby zabil hledaného teroristu?), možná bychom se proto měli pokorně vrátit k hledání nějakých obecných etických principů. Namísto abychom je však UI vštípili pouze „shora“, formou pravidel, pokusíme se k nim přistupovat i „zdola“ a učit je, jak pravidla v praxi používat. Díky této kombinaci obou přístupů si UI sama utvoří jakási prostřední, překlenovací pravidla, díky kterým v konkrétní situaci přemostí obecnost hlavních pravidel a jedinečnost dané situace.

12. 12. 2018 publikovala High-Level Expert Group on Arificial Intelligence při Evropské komisi návrh etických směrnic pro věrohodnou UI (Ethics Guidelines for Trusthworthy AI), v níž se o podobný přístup pokouší. Tato věrohodná UI by měla:

- Respektovat lidskou důstojnost, práva a hodnoty;

- Být technicky natolik robustní, aby byla transparentní a spolehlivá.

Věrohodná UI by měla těchto eticky významných cílů dosáhnout tím, že bude respektovat pět základních etických principů (vzhledem k důrazu na principy se tomuto přístupu říká principlismus): princip dobročinění (čiň dobro), princip neškození (neubližuj), princip autonomie (respektuj autonomii lidských jedinců a neomezuj ji), princip spravedlnosti (jednej s lidmi spravedlivě) a konečně princip transparentnosti (jednej transparentně). Z těchto pěti principů je možné odvozovat konkrétnější a konkrétnější morální normy, jimiž by se UI měla v praxi řídit.

I tento přístup však naráží na určitá úskalí, zvláště když se jednotlivé principy dostanu do sporu a je třeba rozhodnout, který z nich musí dostat přednost. Princip spravedlnosti by například medicínskému expertnímu systému ukládal, že při rozdělování vzácných zdrojů – např. transplantovatelných orgánů – musí spravedlivě zvážit všechny faktory a všechny pacienty. To ale může znamenat, že nad některým pacientem vyřkne ortel smrti, neboť mu odepře vitálně důležitý orgán. Vzhledem k tomu, že i tímto způsobem (neposkytnutí orgánu) způsobí pacientovy újmu, je jeho jednání v souladu či v rozporu s druhým principem? Nebo zvažme řídící software autonomního vozidla, které se v kolizní situaci rozhoduje, jakým směrem se vydá; toto rozhodování je rozhodováním o životě a smrti lidí. Smí taková rozhodování činit? A není zde v rozporu první princip (čiň dobro, tj. zachraň nějakého člověka) s druhým principem (neškoď, tj. nesmíš nikoho zranit či usmrtit)?

Tato dilemata se v případě obecných etických principů budou objevovat neustále a pokud chceme UI naučit, jak v konkrétních případech volit, musíme sami vědět, co v nich je morálně správné a co již není. Problém je samozřejmě v tom, že to mnohdy sami nevíme, proto podobné situace označujeme za morální dilemata.

Jak dál, když nevíme kudy kam?

Viděli jsem, že třebaže současná etika disponuje propracovanými etickými systémy, jejich využití k regulaci chování UI nebude vůbec jednoduché. Možná se budeme muset vzdát představy, že UI se bude muset podřídit jen jedinému etickému systému a představy, že každá forma UI a jejího ztělesnění se bude řídit stejnými etickými pravidly.

Podívejme se opět na autonomní vozidla. Tlak na jejich zavedení do praxe je zřejmý a nepochybně morální povahy: zachráníme tak obrovské množství lidských životů. Je proto dobré, aby AV brázdila naše silnice co nejdříve a aby se celá naše doprava nakonec stala autonomní. Tohoto cíle však nedosáhneme tak, že budeme vyrábět AV, která si lidé nebudou chtít kupovat, jimž odmítnout svěřit své životy a životy svých nejbližších. Možná proto budeme muset vytvořit hybridní etický systém (složený z více než jednoho etického systému), který do určitého poměru škody (jehož hodnotu můžeme určit empirickým výzkumem názorů potenciálních uživatelů AV) bude vždy dávat přednost posádce (bude tedy respektovat obecnou normu „ochraň posádku“), nad tímto poměrem se však začne chovat jako chladný počtář a srovnávat jednotlivé újmy (utilitarismus).

V případě vojenských robotů zase budeme požadovat, aby se v určitých situacích nikdy nechovali jako chladní počtáři sčítající a odečítající životy a řídili se pravidlem „nikdy nesmíš přímo usmrtit civilistu“, zároveň však budeme chtít, aby chápali morální rozdíl mezi přímým zabitím a zabitím nepřímým (např. v případě, že autonomní dron bude bombardovat muniční sklady a předpokládat, že tato akce povede ke smrti nevinných civilistů, které však neusmrtí přímo). Je ale zřejmé, že princip zakazující působit újmu bude muset ustoupit nějaké konkrétnější verzi, aplikovatelné na válečný stav, např. „smíš usmrtit nepřátelského vojáka, nikdy však civilistu.“

Lékařští roboti budou v některých situací jednat ve shodě s utilitarismem (např. při rozhodování o rozdělení vzácného léku), jindy však ne (např. když by uvažovali, zda smějí usmrtit jednoho pacienta a jeho orgány použít na záchranu životů pěti jiných pacientů). Kromě toho budou muset získat jasná pravidla vysvětlující pojem újmy; újmou v kontextu operace není amputace nohy, třebaže v jiném kontextu nepochybně újmou je. Ani v případě aplikace prvního principu nebudou mít snadnou situaci. Pro některé pacienty může být dobré zemřít (trpí neutišitelnou bolestí), bude tedy eutanazie v souladu s tímto principem? Může s ním být v souladu zatajení vážnosti diagnózy z paternalistických důvodů (ve prospěch pacienta)? A opět, nebude to v rozporu s principem autonomie? Na druhou stranu, existují situace, kdy je pacientovi lepší diagnózu v plné šíři a závažnosti nesdělit (terapeutické privilegium), měla by tedy UI upřednostnit princip neškození před principem ukládající respekt k lidské autonomie? Jak ji naučíme tyto delikátní situace rozlišovat?

Všechny tyto problémy ukazují, že zatím více méně tápeme v temnotách. Prozatím to není velký problém, protože UI zatím dokáže řešit jen úzce vymezené problémy v daných oblastech, pro něž není tak obtížné stanovit nějaká etická pravidla. S narůstáním schopností UI a šířkou jejích aplikací ve společnosti se však potřeba jasně stanovit etická pravidla jejich chování stane skutečně urgentní a přijít s nějakým dobrým a široce přijímaným řešením nebude vůbec snadné.

Vyšlo v časopise Computerworld.

Cookies