Novinky

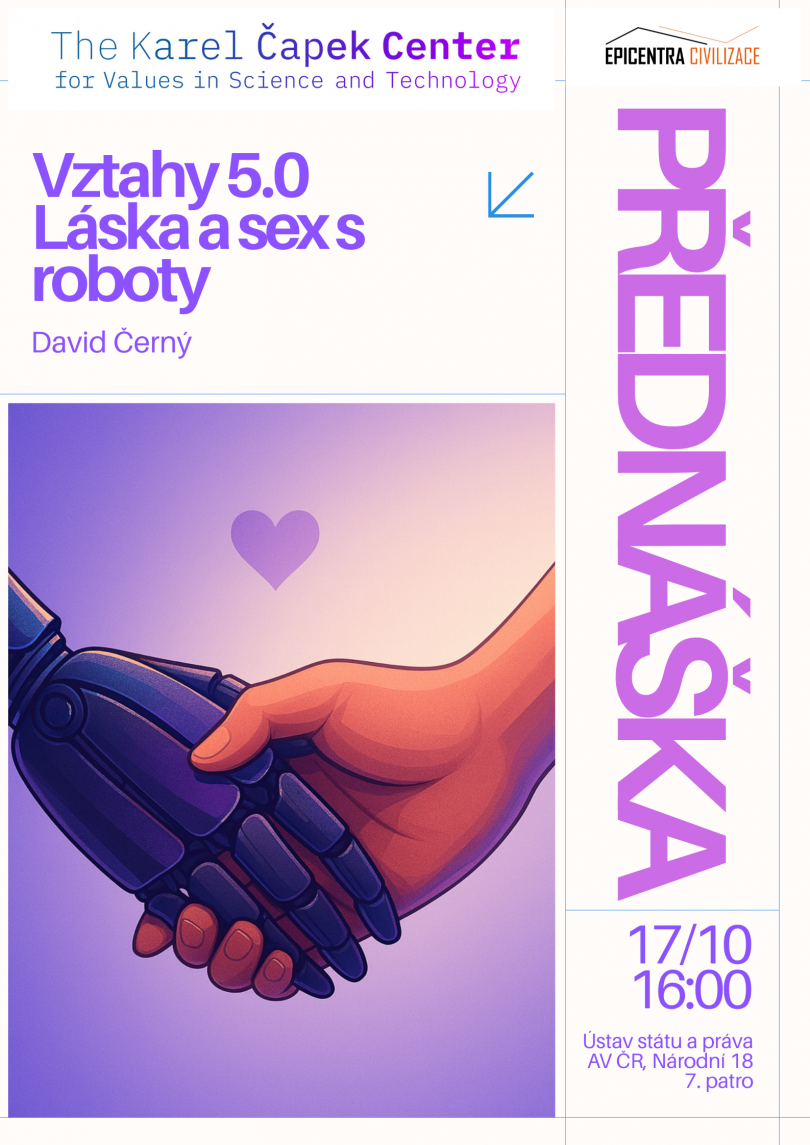

Vztahy 5.0 Láska a sex s roboty

Pozvánka na přednášku

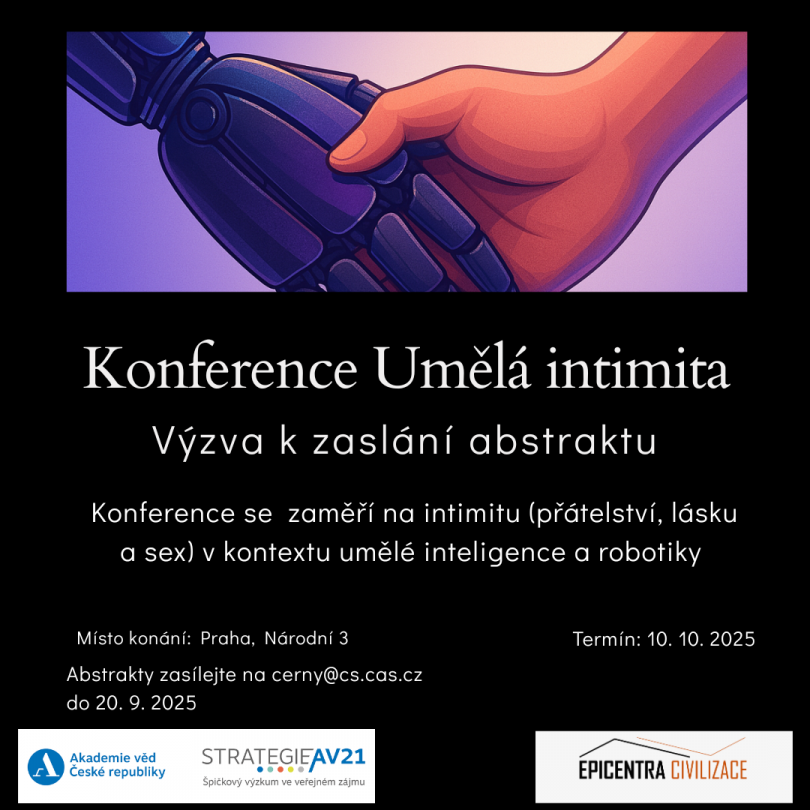

Konference Umělá intimita

Program konference

Konference Umělá intimita

Výzva k zaslání abstraktu

COMMUNICATIVE AI

Křest knihy

Ve středu 14. května se bude v hl. budově Akademie věd AV ČR na Národní 3 konat světový křest nové knihy Davida Gunkela a Marka Coeckelbergha COMMUNICATIVE AI: A CRITICAL INTRODUCTION TO LARGE LANGUAGE MODELS (Polity 2025). Jak zájemci o Centrum Karla Čapka vědí, Mark Coeckelbergh je naším externím členem, a rovněž členem spráteleného Centra pro environmentální a technologickou etiku (CETE-P) na Filosofickém ústavu AV ČR. David Gunkel je americký filosof, známý z mnoha monografií na témata z filosofie robotiky a umělé inteligence (The Machine Question, Robot Rights, Person Thing Robot ad.).

Akce je otevřena široké veřejnosti a všichni zájemci jsou vítáni!

© 2018, Centrum Karla Čapka pro studium hodnot ve vědě a technice

Cookies

Cookies